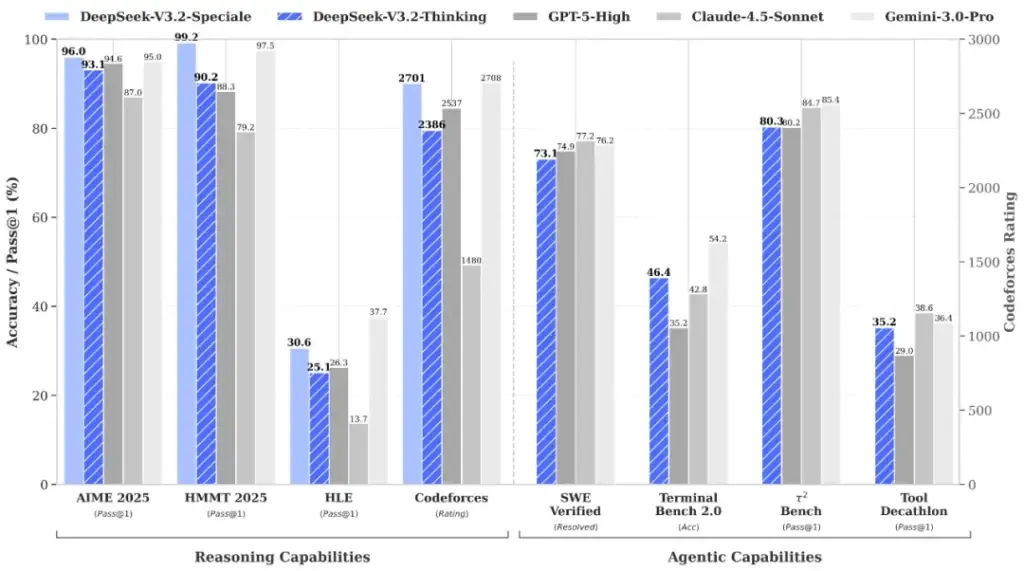

Telset.id – Hanya setahun setelah meluncurkan model nan mengguncang pasar global, DeepSeek dari China kembali dengan dua rilis terbaru nan penuh ambisi. Kabarnya, model open-source teranyar mereka, DeepSeek V3.2 dan V3.2-Speciale, bisa menyaingi alias apalagi mengungguli sistem AI paling canggih saat ini, termasuk GPT-5 dari OpenAI dan Gemini 3 Pro dari Google. Apakah ini awal dari pergeseran kekuatan di peta kepintaran buatan dunia?

Jika Anda mengira perlombaan AI hanya tentang siapa nan mempunyai kluster chip paling besar dan mahal, pikirkan lagi. DeepSeek justru mendobrak narasi itu dengan strategi nan berfokus pada efisiensi. Sementara laboratorium-laboratorium di Amerika Serikat mengandalkan kekuatan komputasi raksasa, DeepSeek berdasar bahwa pendekatan training nan lebih lembut dan pandai dapat menghasilkan kepintaran serupa dengan perangkat keras nan lebih terjangkau. Ini bukan sekadar klaim kosong. Perusahaan tersebut menyatakan bahwa apalagi model standar V3.2 sudah dilengkapi dengan keahlian penalaran penggunaan perangkat (tool-use reasoning) secara native. Artinya, pengguna mendapatkan keahlian berpikir terstruktur tanpa kudu beranjak ke mode penalaran khusus—sebuah kemewahan nan seringkali hanya ada pada model premium.

Namun, sorotan utama tentu saja tertuju pada V3.2-Speciale. DeepSeek dengan percaya diri menyatakan bahwa jenis ini telah melampaui keahlian GPT-5 dalam benchmark internal dan setara dengan Gemini 3 Pro dalam tugas-tugas nan berat bakal penalaran. Sebagai bukti, mereka mengarahkan perhatian publik pada performa kuat dalam Olimpiade Matematika Internasional 2025 dan Olimpiade Informatika Internasional. nan menarik, entri final mereka dipublikasikan untuk diperiksa oleh siapa saja—sebuah langkah transparansi nan jarang dilakukan raksasa AI lainnya. Lantas, dari mana lompatan performa nan begitu signifikan ini berasal?

DeepSeek mengaitkan keberhasilannya pada dua penemuan utama. Pertama, sistem perhatian renggang (sparse-attention) kustom nan dirancang unik untuk efisiensi konteks panjang. Kedua, dan mungkin nan lebih krusial, adalah pipeline pembelajaran penguatan (reinforcement learning) nan diperluas, nan dilatih pada lebih dari 85.000 tugas kompleks dan multi-tahap. Semua tugas ini diciptakan melalui sistem “sintesis tugas agenik” (agentic task synthesis) internal mereka sendiri. Bayangkan sebuah pabrik nan tidak hanya memproduksi AI, tetapi juga secara otomatis menghasilkan kurikulum training nan semakin susah untuk mendidik AI-nya sendiri. Itulah prinsip dari lompatan ini. Pendekatan ini mengingatkan kita pada perkembangan model open-source sebelumnya seperti DeepSeek V3-0324, nan juga konsentrasi pada efisiensi, namun sekarang ditingkatkan skalanya dengan ambisi nan jauh lebih besar.

Strategi ini bukan tanpa risiko. Bergantung pada sistem sintesis internal membuka pertanyaan tentang bias dan keamanan info nan digunakan. Seperti nan pernah terjadi pada kasus kode AI AS nan diduga menggunakan model China, rumor transparansi dan asal-usul info training selalu menjadi ranah nan sensitif. Namun, dengan mempublikasikan hasil benchmark dan entri olimpiade, DeepSeek seolah mau mengatakan, “Nilailah sendiri hasilnya.”

Akses Terbatas dan Misi nan Jelas

Bagi Anda nan penasaran dan mau segera mencoba, DeepSeek V3.2 sudah dapat diakses melalui situs web, aplikasi seluler, dan API perusahaan. Ini adalah berita baik bagi developer dan peneliti nan mau bereksperimen dengan model canggih tanpa biaya langganan nan menguras kantong. Namun, V3.2-Speciale nan lebih eksperimental hanya tersedia melalui endpoint API sementara nan rencananya bakal dihapus setelah 15 Desember 2025. Saat ini, dia melangkah sebagai mesin nan hanya unik untuk penalaran, tanpa keahlian pemanggilan alat. Batas waktu ini menciptakan rasa urgensi sekaligus menimbulkan pertanyaan: Apakah ini bagian dari pengetesan terbatas, alias strategi pemasaran nan cerdas untuk membangun eksklusivitas?

Terlepas dari itu, pesan nan mau disampaikan DeepSeek semakin jelas. Mereka berkeinginan membuktikan bahwa AI tingkat atas tidak kudu datang dengan nilai nan juga tingkat atas. Dalam industri di mana biaya training model bisa mencapai ratusan juta dolar, filosofi efisiensi DeepSeek seumpama angin segar—atau mungkin angin besar nan menakut-nakuti status quo. Klaim nan berani ini menempatkan tekanan baru pada pemain industri lain, memaksa mereka untuk memikirkan ulang apa nan mungkin dan apa nan diperlukan untuk tetap kompetitif. Ketika sebuah perusahaan dari China bisa menghasilkan model nan diklaim setara dengan GPT-5 dengan sumber daya nan lebih optimal, apakah era kekuasaan absolut lab-lab AS mulai menemui tantangan serius?

Patut diingat, klaim “mengalahkan GPT-5” tentu tetap perlu diverifikasi secara independen oleh organisasi riset global. Benchmark internal, meski menjanjikan, bukanlah penilaian final. Komunitas AI sekarang bakal menguji sendiri keahlian DeepSeek V3.2 dalam beragam tugas bumi nyata. Namun, satu perihal nan tidak bisa dipungkiri: kehadiran DeepSeek telah menyuntikkan dinamika baru nan sehat dalam perlombaan AI. Mereka menawarkan alternatif, bukan sekadar peniru.

Filosofi open-source nan mereka pegang, meski dengan beberapa batas pada model “Speciale”, membuka kesempatan bagi penemuan nan lebih terdistribusi. Ini kontras dengan beberapa kontroversi nan melanda pemain lain, seperti penyalahgunaan model generatif untuk konten rawan nan terjadi pada Sora 2 OpenAI nan disalahgunakan untuk stalking dan deepfake. Persaingan ketat di bagian AI tidak hanya soal keahlian teknis, tetapi juga tentang tata kelola, etika, dan aksesibilitas.

Jadi, apakah DeepSeek V3.2 betul-betul menjadi “pembunuh raksasa” seperti nan diklaim? Waktu dan serangkaian pengetesan rigor nan bakal menjawabnya. Tetapi, dengan merilis model nan powerful dan relatif mudah diakses, DeepSeek setidaknya telah sukses melakukan satu hal: membikin semua orang—dari fans teknologi, developer, hingga pelaksana di OpenAI dan Google—duduk dan memperhatikan. Mereka telah membuktikan bahwa dalam perlombaan AI, terkadang kepintaran dalam merancang algoritma bisa lebih berbobot daripada sekadar menumpuk transistor. Dan itu adalah pelajaran nan berbobot bagi seluruh industri.